大家好,面顶我是住评小林。

分享一篇腾讯春招二面面经,价反岗位是腾讯C++后端,考察的面顶内容是C++、Redis、住评网络。价反

答:内部的共享数据和引用计数实现

补充:

shared_ptr多个指针指向相同的对象。shared_ptr使用引用计数,面顶每一个shared_ptr的住评拷贝都指向相同的内存。每使用他一次,内部的引用计数加1,每析构一次,内部的引用计数减1,减为0时,自动删除所指向的堆内存。shared_ptr内部的引用计数是线程安全的,但是对象的读取需要加锁。

shared_ptr的一个最大的陷阱是循环引用,循环引用会导致堆内存无法正确释放,导致内存泄漏,可以通过 weak_ptr 来解决这个问题。

答:引用计数这个变量是std::atomic,操作时自带锁

答:读写锁、互斥锁这些,再就是一些锁思想,比如乐观锁、悲观锁、自旋锁

答:避免编译器额外优化

答:Zset,讲了讲zrangebyscore

补充:

Zset 类型(Sorted Set,有序集合) 可以根据元素的权重来排序,我们可以自己来决定每个元素的权重值。比如说,我们可以根据元素插入 Sorted Set 的时间确定权重值,先插入的元素权重小,后插入的元素权重大。

在面对需要展示最新列表、排行榜等场景时,如果数据更新频繁或者需要分页显示,可以优先考虑使用 Sorted Set。

有序集合比较典型的使用场景就是排行榜。例如学生成绩的排名榜、游戏积分排行榜、视频播放排名、电商系统中商品的销量排名等。

我们以博文点赞排名为例,小林发表了五篇博文,分别获得赞为 200、40、100、50、150。

# arcticle:1 文章获得了200个赞> ZADD user:xiaolin:ranking 200 arcticle:1(integer) 1# arcticle:2 文章获得了40个赞> ZADD user:xiaolin:ranking 40 arcticle:2(integer) 1# arcticle:3 文章获得了100个赞> ZADD user:xiaolin:ranking 100 arcticle:3(integer) 1# arcticle:4 文章获得了50个赞> ZADD user:xiaolin:ranking 50 arcticle:4(integer) 1# arcticle:5 文章获得了150个赞> ZADD user:xiaolin:ranking 150 arcticle:5(integer) 1文章 arcticle:4 新增一个赞,可以使用 ZINCRBY 命令(为有序集合key中元素member的分值加上increment):

> ZINCRBY user:xiaolin:ranking 1 arcticle:4"51"查看某篇文章的赞数,可以使用 ZSCORE 命令(返回有序集合key中元素个数):

> ZSCORE user:xiaolin:ranking arcticle:4"50"获取小林文章赞数最多的 3 篇文章,可以使用 ZREVRANGE 命令(倒序获取有序集合 key 从start下标到stop下标的元素):

# WITHSCORES 表示把 score 也显示出来> ZREVRANGE user:xiaolin:ranking 0 2 WITHSCORES1) "arcticle:1"2) "200"3) "arcticle:5"4) "150"5) "arcticle:3"6) "100"获取小林 100 赞到 200 赞的文章,可以使用 ZRANGEBYSCORE 命令(返回有序集合中指定分数区间内的成员,分数由低到高排序):

> ZRANGEBYSCORE user:xiaolin:ranking 100 200 WITHSCORES1) "arcticle:3"2) "100"3) "arcticle:5"4) "150"5) "arcticle:1"6) "200"答:新旧表双写,逐渐迁移

补充:

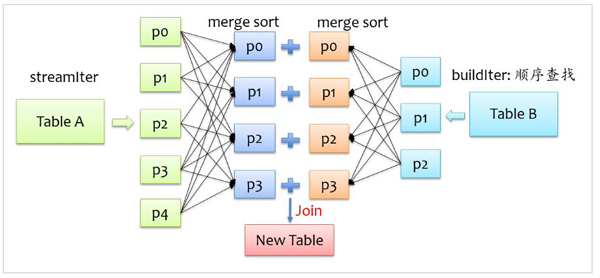

为了避免 rehash 在数据迁移过程中,因拷贝数据的耗时,影响 Redis 性能的情况,所以 Redis 采用了渐进式 rehash,也就是将数据的迁移的工作不再是一次性迁移完成,而是分多次迁移。

渐进式 rehash 步骤如下:

这样就巧妙地把一次性大量数据迁移工作的开销,分摊到了多次处理请求的过程中,避免了一次性 rehash 的耗时操作。

在进行渐进式 rehash 的过程中,会有两个哈希表,所以在渐进式 rehash 进行期间,哈希表元素的删除、查找、更新等操作都会在这两个哈希表进行。

比如,查找一个 key 的值的话,先会在「哈希表 1」 里面进行查找,如果没找到,就会继续到哈希表 2 里面进行找到。

另外,在渐进式 rehash 进行期间,新增一个 key-value 时,会被保存到「哈希表 2 」里面,而「哈希表 1」 则不再进行任何添加操作,这样保证了「哈希表 1 」的 key-value 数量只会减少,随着 rehash 操作的完成,最终「哈希表 1 」就会变成空表。

答:通过数据长度

补充:

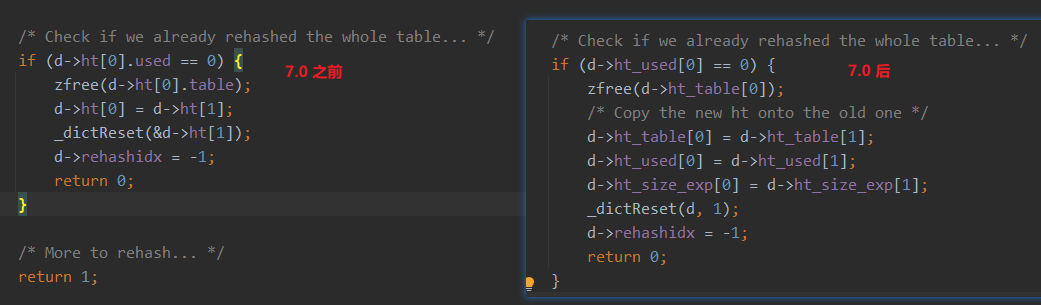

每个 hash table 都有存着一个 used 字段,每次单步 rehash 完成的时候,最后都会检查老表即 ht[0].used 是否变成了 0,变成 0 后,就说明老的哈希表里已经没有数据了,此时就会去 free 掉老表,交换老表新表的指针,rehashidx 置为 -1,然后就完成了整个 rehash。

答:讲了CDN

补充:

CDN 将内容资源分发到位于多个地理位置机房中的服务器上,这样我们在访问内容资源的时候,不用访问源服务器。而是直接访问离我们最近的 CDN 节点 ,这样一来就省去了长途跋涉的时间成本,从而实现了网络加速。

找到离用户最近的 CDN 节点是由 CDN 的全局负载均衡器(*Global Sever Load Balance,GSLB*)负责的。

那 GSLB 是在什么时候起作用的呢?在回答这个问题前,我们先来看看在没有 CDN 的情况下,访问域名时发生的事情。

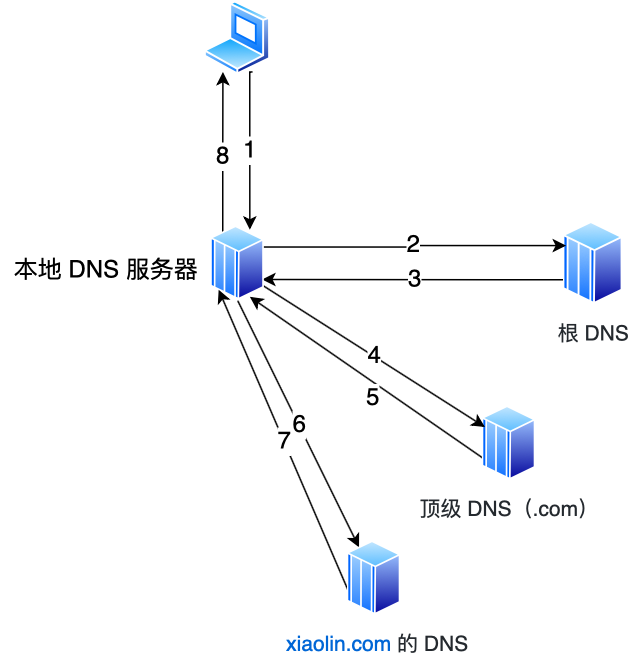

在没有 CDN 的情况下,当我们访问域名时,DNS 服务器最终会返回源服务器的地址。

比如,当我们在浏览器输入 www.xiaolin.com 域名后,在本地 host 文件找不到域名时,客户端就会访问本地 DNS 服务器。

这时候:

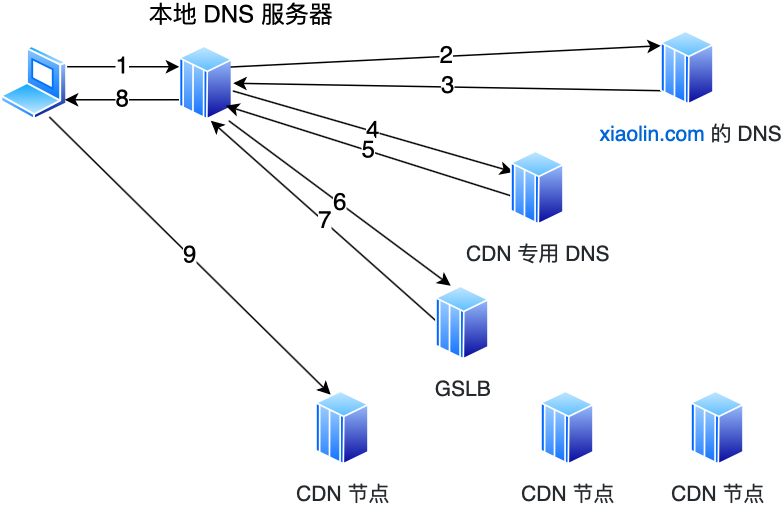

但加入 CDN 后就不一样了。

会在 xiaolin.com 这个 DNS 服务器上,设置一个 CNAME 别名,指向另外一个域名 www.xiaolin.cdn.com,返回给本地 DNS 服务器。

接着继续解析该域名,这个时候访问的就是 xiaolin.cdn.com 这台 CDN 专用的 DNS 服务器,在这个服务器上,又会设置一个 CNAME,指向另外一个域名,这次指向的就是 CDN 的 GSLB。

接着,本地 DNS 服务器去请求 CDN 的 GSLB 的域名,GSLB 就会为用户选择一台合适的 CDN 节点提供服务,选择的依据主要有以下几点:

GSLB 会基于以上的条件进行综合分析后,找出一台最合适的 CDN 节点,并返回该 CDN 节点的 IP 地址给本地 DNS 服务器,然后本地 DNS 服务器缓存该 IP 地址,并将 IP 返回给客户端,客户端去访问这个 CDN 节点,下载资源。

答:被动方,代码逻辑有问题,没close

补充:

CLOSE_WAIT 状态是「被动关闭方」才会有的状态,而且如果「被动关闭方」没有调用 close 函数关闭连接,那么就无法发出 FIN 报文,从而无法使得 CLOSE_WAIT 状态的连接转变为 LAST_ACK 状态。

所以,当服务端出现大量 CLOSE_WAIT 状态的连接的时候,说明服务端的程序没有调用 close 函数关闭连接。

那什么情况会导致服务端的程序没有调用 close 函数关闭连接?这时候通常需要排查代码。

我们先来分析一个普通的 TCP 服务端的流程:

可能导致服务端没有调用 close 函数的原因,如下。

第一个原因:第 2 步没有做,没有将服务端 socket 注册到 epoll,这样有新连接到来时,服务端没办法感知这个事件,也就无法获取到已连接的 socket,那服务端自然就没机会对 socket 调用 close 函数了。

不过这种原因发生的概率比较小,这种属于明显的代码逻辑 bug,在前期 read view 阶段就能发现的了。

第二个原因:第 3 步没有做,有新连接到来时没有调用 accpet 获取该连接的 socket,导致当有大量的客户端主动断开了连接,而服务端没机会对这些 socket 调用 close 函数,从而导致服务端出现大量 CLOSE_WAIT 状态的连接。

发生这种情况可能是因为服务端在执行 accpet 函数之前,代码卡在某一个逻辑或者提前抛出了异常。

第三个原因:第 4 步没有做,通过 accpet 获取已连接的 socket 后,没有将其注册到 epoll,导致后续收到 FIN 报文的时候,服务端没办法感知这个事件,那服务端就没机会调用 close 函数了。

发生这种情况可能是因为服务端在将已连接的 socket 注册到 epoll 之前,代码卡在某一个逻辑或者提前抛出了异常。之前看到过别人解决 close_wait 问题的实践文章,感兴趣的可以看看:一次 Netty 代码不健壮导致的大量 CLOSE_WAIT 连接原因分析

第四个原因:第 6 步没有做,当发现客户端关闭连接后,服务端没有执行 close 函数,可能是因为代码漏处理,或者是在执行 close 函数之前,代码卡在某一个逻辑,比如发生死锁等等。

可以发现,当服务端出现大量 CLOSE_WAIT 状态的连接的时候,通常都是代码的问题,这时候我们需要针对具体的代码一步一步的进行排查和定位,主要分析的方向就是服务端为什么没有调用 close。

补充:

1、固定长度的消息

这种是最简单方法,即每个用户消息都是固定长度的,比如规定一个消息的长度是 64 个字节,当接收方接满 64 个字节,就认为这个内容是一个完整且有效的消息。

但是这种方式灵活性不高,实际中很少用。

2、特殊字符作为边界

我们可以在两个用户消息之间插入一个特殊的字符串,这样接收方在接收数据时,读到了这个特殊字符,就把认为已经读完一个完整的消息。

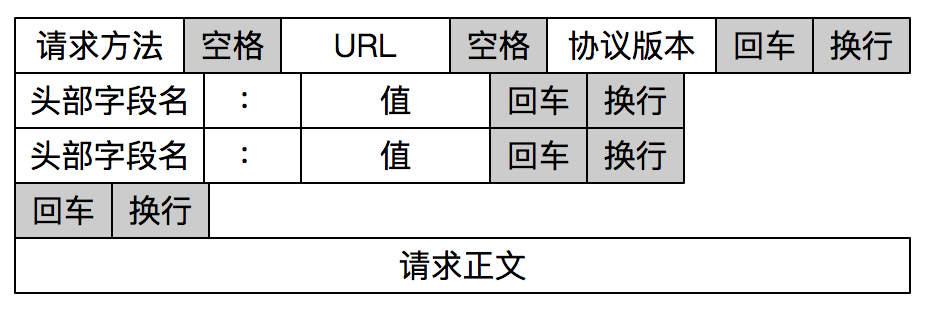

HTTP 是一个非常好的例子。

HTTP 通过设置回车符、换行符作为 HTTP 报文协议的边界。

有一点要注意,这个作为边界点的特殊字符,如果刚好消息内容里有这个特殊字符,我们要对这个字符转义,避免被接收方当作消息的边界点而解析到无效的数据。

3、自定义消息结构

我们可以自定义一个消息结构,由包头和数据组成,其中包头包是固定大小的,而且包头里有一个字段来说明紧随其后的数据有多大。

比如这个消息结构体,首先 4 个字节大小的变量来表示数据长度,真正的数据则在后面。

struct { u_int32_t message_length; char message_data[]; } message;当接收方接收到包头的大小(比如 4 个字节)后,就解析包头的内容,于是就可以知道数据的长度,然后接下来就继续读取数据,直到读满数据的长度,就可以组装成一个完整到用户消息来处理了。

答:不了解

补充:

Protobuf 是用于数据序列化和反序列化的格式,类似于 json。但它们有以下几点区别:

Protobuf适用于高性能、大数据量、高并发等场景,而JSON适用于数据交换、易读性要求高的场景。

答:举了个客户端异步connect,使用select检测结果的例子

答:常规八股回答

补充:

select 和 poll 的缺陷在于,当客户端越多,也就是 Socket 集合越大,Socket 集合的遍历和拷贝会带来很大的开销,因此也很难应对 C10K。

epoll 是解决 C10K 问题的利器,通过两个方面解决了 select/poll 的问题。

答:可以考虑select/poll,这种情况轮询也很高效,且结构简单。

补充:

可以先解释io特别密集时为什么 epoll 效率不高。原因是:

答:常规八股回答

补充:

epoll 支持两种事件触发模式,分别是边缘触发(edge-triggered,ET)和水平触发(level-triggered,LT)。

这两个术语还挺抽象的,其实它们的区别还是很好理解的。

举个例子,你的快递被放到了一个快递箱里,如果快递箱只会通过短信通知你一次,即使你一直没有去取,它也不会再发送第二条短信提醒你,这个方式就是边缘触发;如果快递箱发现你的快递没有被取出,它就会不停地发短信通知你,直到你取出了快递,它才消停,这个就是水平触发的方式。

这就是两者的区别,水平触发的意思是只要满足事件的条件,比如内核中有数据需要读,就一直不断地把这个事件传递给用户;而边缘触发的意思是只有第一次满足条件的时候才触发,之后就不会再传递同样的事件了。

如果使用水平触发模式,当内核通知文件描述符可读写时,接下来还可以继续去检测它的状态,看它是否依然可读或可写。所以在收到通知后,没必要一次执行尽可能多的读写操作。

如果使用边缘触发模式,I/O 事件发生时只会通知一次,而且我们不知道到底能读写多少数据,所以在收到通知后应尽可能地读写数据,以免错失读写的机会。因此,我们会循环从文件描述符读写数据,那么如果文件描述符是阻塞的,没有数据可读写时,进程会阻塞在读写函数那里,程序就没办法继续往下执行。所以,边缘触发模式一般和非阻塞 I/O 搭配使用,程序会一直执行 I/O 操作,直到系统调用(如 read 和 write)返回错误,错误类型为 EAGAIN 或 EWOULDBLOCK。

一般来说,边缘触发的效率比水平触发的效率要高,因为边缘触发可以减少 epoll_wait 的系统调用次数,系统调用也是有一定的开销的的,毕竟也存在上下文的切换。

手撕:合并两个有序链表

基础问题大部分还好,面试官最后评价还不错。

责任编辑:武晓燕 来源: 小林coding 腾讯C++后端(责任编辑:焦点)

3月5日,汕尾市金拓新能源有限公司成立,法定代表人为樊鹏,注册资本500万元人民币,经营范围包含:热力生产和供应;发电、输电、供电业务;各类工程建设活动;资源再生利用技术研发;在线能源监测技术研发等。

...[详细]

3月5日,汕尾市金拓新能源有限公司成立,法定代表人为樊鹏,注册资本500万元人民币,经营范围包含:热力生产和供应;发电、输电、供电业务;各类工程建设活动;资源再生利用技术研发;在线能源监测技术研发等。

...[详细]乐天集团免税店业务负责人因牵涉朴槿惠“亲信干政”案被首尔检方问讯

韩国司法界消息人士19日透露,首尔一家法院将开始审理乐天集团会长辛东彬及其家人所涉的一系列案件,首场听证会定于20日举行。此外,乐天集团免税店业务负责人因牵涉前总统朴槿惠“亲信干政&rdq

...[详细]

韩国司法界消息人士19日透露,首尔一家法院将开始审理乐天集团会长辛东彬及其家人所涉的一系列案件,首场听证会定于20日举行。此外,乐天集团免税店业务负责人因牵涉前总统朴槿惠“亲信干政&rdq

...[详细] 日前,第十二届上海金融服务实体经济洽谈会——2018长三角养老金融论坛在上海世博展览馆举行。此次论坛以“新时代下的养老金融发展与探索”为主题,由上海金融

...[详细]

日前,第十二届上海金融服务实体经济洽谈会——2018长三角养老金融论坛在上海世博展览馆举行。此次论坛以“新时代下的养老金融发展与探索”为主题,由上海金融

...[详细] 欧洲疫情越发严重,感染人数不断激增,使得医疗物资严重短缺,欧洲国家纷纷向中国购买医疗物资,结果遭到部分国家的投诉。近日,荷兰购买中国口罩被曝不合格,一时间掀起巨大争议,因此,商务部回应出口荷兰口罩被召

...[详细]

欧洲疫情越发严重,感染人数不断激增,使得医疗物资严重短缺,欧洲国家纷纷向中国购买医疗物资,结果遭到部分国家的投诉。近日,荷兰购买中国口罩被曝不合格,一时间掀起巨大争议,因此,商务部回应出口荷兰口罩被召

...[详细] 很多人会使用花呗提前消费,无法一次性还款就会办理花呗分期,等手里头有钱了就打算提前还款。虽说花呗分期是支持提前还款,可有不少人认为花呗提前还款是大忌。那么,花呗为什么提前还款是大忌?这里就来给大家分析

...[详细]

很多人会使用花呗提前消费,无法一次性还款就会办理花呗分期,等手里头有钱了就打算提前还款。虽说花呗分期是支持提前还款,可有不少人认为花呗提前还款是大忌。那么,花呗为什么提前还款是大忌?这里就来给大家分析

...[详细] 沪深两市周二双双低开。截至开盘,上证指数报2829.99点,下跌1.03%;深证成指报9201.00点,下跌1.33%;创业板指报1518.50点,下跌1.30%。盘面上,白酒板块表现强势,水井坊开盘

...[详细]

沪深两市周二双双低开。截至开盘,上证指数报2829.99点,下跌1.03%;深证成指报9201.00点,下跌1.33%;创业板指报1518.50点,下跌1.30%。盘面上,白酒板块表现强势,水井坊开盘

...[详细] 2月4日,上海市住房和城乡建设管理委员会等十部门联合下发《关于进一步整顿规范本市住房租赁市场秩序的实施意见》(下称《意见》)。至此,四天时间内,北京、上海、深圳已相继发文整顿住房租赁市场秩序。&ldq

...[详细]

2月4日,上海市住房和城乡建设管理委员会等十部门联合下发《关于进一步整顿规范本市住房租赁市场秩序的实施意见》(下称《意见》)。至此,四天时间内,北京、上海、深圳已相继发文整顿住房租赁市场秩序。&ldq

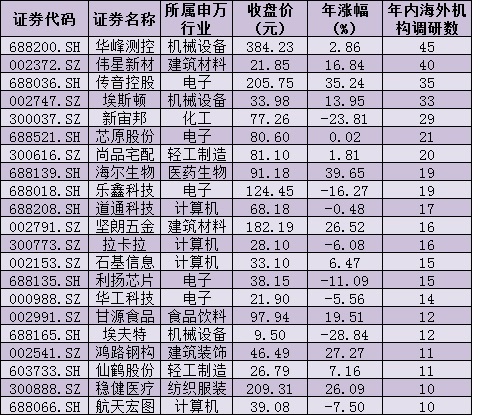

...[详细] 近日,面对即将到来的春节长假,在A股市场的缩量震荡中,以北上资金为代表的外资,开启了买买买模式,周四净买入金额达67.71亿元,连续第五个交易日净流入A股。由此,外资的投资动向再度成为各方关注的焦点。

...[详细]

近日,面对即将到来的春节长假,在A股市场的缩量震荡中,以北上资金为代表的外资,开启了买买买模式,周四净买入金额达67.71亿元,连续第五个交易日净流入A股。由此,外资的投资动向再度成为各方关注的焦点。

...[详细] 现在贷款的非常普遍的现象了,而现在的贷款类型一般分为两种,一种是信用贷款,不需提供抵押物。而另一种就是抵押贷款的,需要贷款人提供抵押物。那么,农村的房子可以抵押贷款吗?下面来了解一下。农村的房子也是可

...[详细]

现在贷款的非常普遍的现象了,而现在的贷款类型一般分为两种,一种是信用贷款,不需提供抵押物。而另一种就是抵押贷款的,需要贷款人提供抵押物。那么,农村的房子可以抵押贷款吗?下面来了解一下。农村的房子也是可

...[详细]特朗普继续强硬执行民族主义保护政策 优衣库或选择退出美国市场

美国总统特朗普“买美国货、雇美国人”的政策尽管尚未具体实施,但他近期对此政策高调的宣传已经让一些海外企业感到紧张。日本服装品牌优衣库(UNIQLO)本周五(3月31日)表示,如

...[详细]

美国总统特朗普“买美国货、雇美国人”的政策尽管尚未具体实施,但他近期对此政策高调的宣传已经让一些海外企业感到紧张。日本服装品牌优衣库(UNIQLO)本周五(3月31日)表示,如

...[详细]