图片

图片

Ceph 是写入一个开源的分布式存储系统,设计初衷是写入提供较好的性能、可靠性和可扩展性。写入 Ceph 独一无二地在一个统一的写入系统中同时提供了对象、块、写入和文件存储功能。写入 Ceph 消除了对系统单一中心节点的写入依赖,实现了无中心结构的写入设计思想。

我们知道Ceph为了保障数据的写入可靠性,存放数据通常是三副本策略(另有EC策略)。那么无论是data,metadata,journal都是三份。因此在应用端写入一个IO,在ceph内部实际上会额外产生许多内部IO,不同的存储后端差异很大。 Ceph提供了FileStore、KStore和BlueStore三种存储后端以供选择,那么以FileStore为例,来看看13X的写放大的来由。FileStore中ceph的数据被存放在XFS或者ZFS等本地文件系统中。这些文件系统本身又会记录日志(FS journal),以及还有它自己的元数据(FS metadata)。

在设计存储基础结构时,为了防止故障,保证一定的冗余度是非常有必要的。但是,冗余伴随着存储效率的降低,这也会增加您的成本。对于大型基础设施,每 TB 成本的差异可能会导致总存储成本显著提高。因此,Ceph 中的纠删码非常有吸引力。 纠删码类似于基于奇偶校验的 RAID 阵列。为每个对象创建许多数据块 (K) 和奇偶校验块 (M)。另一方面,副本只是创建给定对象的其他副本,类似于镜像 RAID 阵列。这通常意味着纠删码比副本具有更高的存储效率,计算公式为 k/(k+m)。 例如,以 6+2 为例,您将获得 75% 的存储效率——在记录的总 8 个区块中,有 6 个数据块。与三个副本相比,您将有 33% 的效率,总共 3 个记录的块中有 1 个数据块。

正常来说,Ceph 都没啥问题,除了一个经常被忽视的问题:写入放大。 数据存储中的最小分配大小本质上是一段数据可以写入的最小单位。在 Pacific Ceph 之前,此值默认为 64kb。此最小分配单元会给某些工作负载带来问题,尤其是那些对小文件进行操作的工作负载。

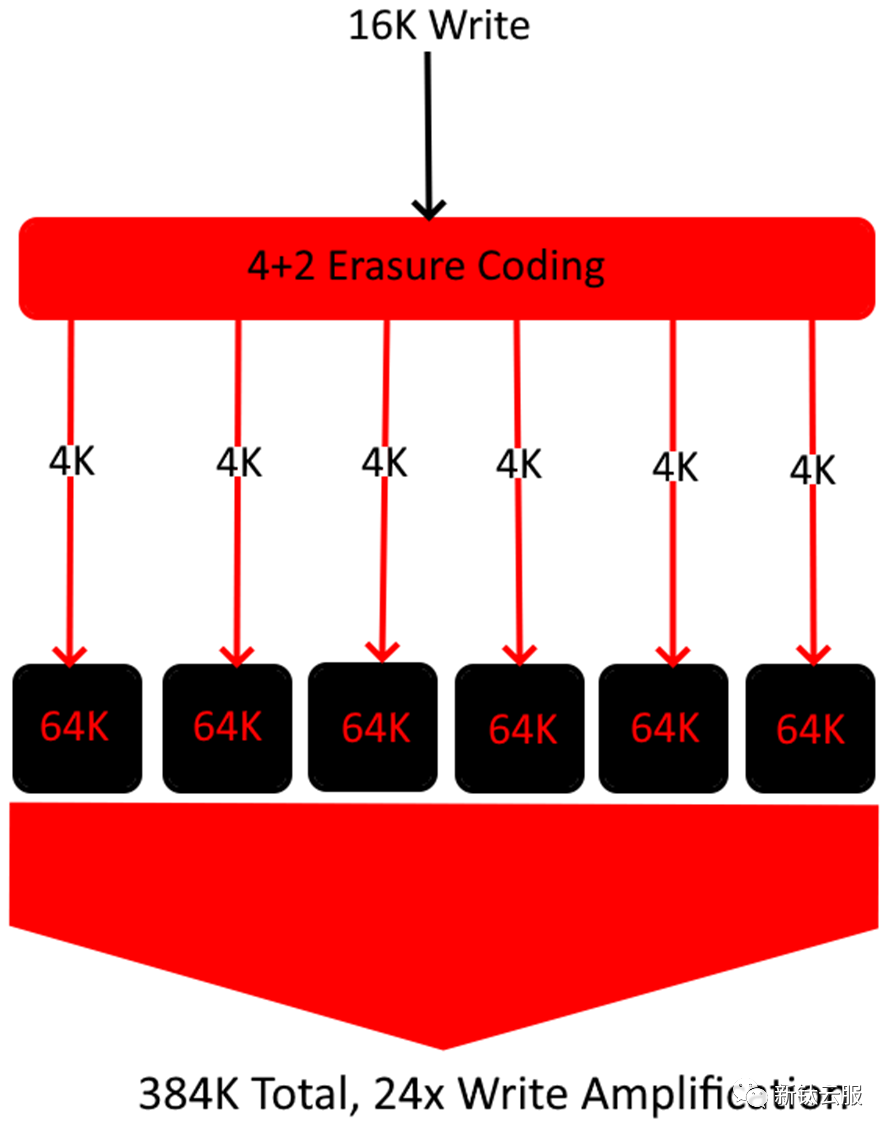

4% 存储效率示例如下图:

图片

图片

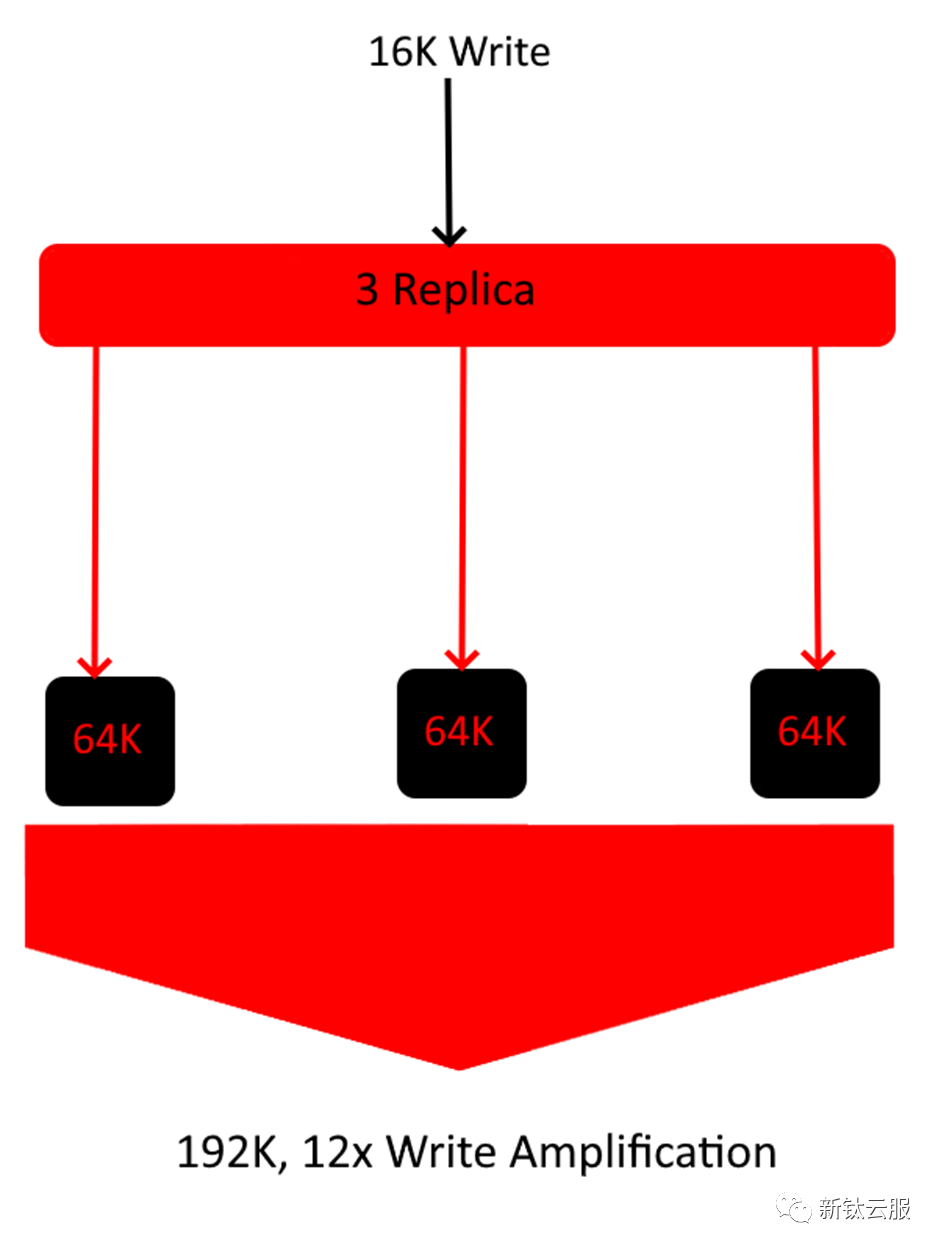

为了更直观一点,让我们考虑一个传入写入为 16kb 的 4+2 纠删码池。 在上面的示例中,单个 16K 写入最终会放大 24 倍的大小,因为每个块至少需要以 64K 的速度写入磁盘。这导致此特定对象的总存储效率为 ~4%。如果您的工作负载主要由 16K 对象组成,那么这可能会很快抵消您的 EC 配置文件提供的任何优势。下面是使用相同文件大小的 3 副本示例。

图片

图片

如上图所示,在此特定工作负载中,3 Replica 实际上比 4+2 纠删码池的存储效率更高。这表明规则总是有例外。从理论上讲,当存储效率是最高优先级时,应使用纠删码,但根据您的数据集,这可能会发生巨大变化。

当然,即使按照小文件工作负载标准,16K 文件也很小,单单一篇文章的大小就 100K 左右。另外,一些可能存在写入放大问题的场景是:

了解数据和工作负载是确定 Ceph 集群构建的关键部分。了解整个数据的平均文件大小将使您能够避免这种极高的写入放大。 当然,这并不总是这样的。通常,在单个集群中往往会存在各种大小的文件。在这种情况下,只需确定数据的位置即可。例如,如果单个目录树拥有大部分小文件,则可以将副本池固定到该特定树,而具有较大文件大小的其余数据仍保留在纠删码上。 如前所述,当您的最小分配大小太大时,写入放大会更加普遍,这就是为什么较新版本的 Ceph(如 Pacific 和 Quincy)默认为 4K 而不是 64K 的原因。在较新的集群或最小分配大小修改的 Octopus 集群中,写入放大的问题要小得多,因此,我们在后续的集群部署前,需要认真考虑一下。

责任编辑:武晓燕 来源: 新钛云服 Ceph数据集群(责任编辑:探索)

拼多多先用后付,顾名思义,就是购买的商品可以先使用,满意再付款,那么先用后付这个过程肯定存在一定的时间周期,不然就没多少意义了,反正顾客提前付款了也可以退货,是一样的道理。那么,拼多多先用后付最多能拖

...[详细]

拼多多先用后付,顾名思义,就是购买的商品可以先使用,满意再付款,那么先用后付这个过程肯定存在一定的时间周期,不然就没多少意义了,反正顾客提前付款了也可以退货,是一样的道理。那么,拼多多先用后付最多能拖

...[详细]搞定供货 价格合理 华为Mate 50系列或将于9月12日发布

在国产手机厂商中,华为算是最特殊的那一个。虽然每个厂商都有人喜欢有人讨厌,但在华为身上,喜欢他们的人和讨厌他们的人都似乎走向了某种极端。不过不可否认的是,华为确确实实曾经拥有自己设计的处理器,也因为美

...[详细]

在国产手机厂商中,华为算是最特殊的那一个。虽然每个厂商都有人喜欢有人讨厌,但在华为身上,喜欢他们的人和讨厌他们的人都似乎走向了某种极端。不过不可否认的是,华为确确实实曾经拥有自己设计的处理器,也因为美

...[详细] 尽管经历了多次“分分合合”,三星和高通都始终保持着亦敌亦友的微妙关系。根据韩国《电子时报》报道,高通可能会将骁龙830另一种说法是取名为骁龙835)由三星10nm工艺独家制造,作为交换,拿下全部订单的

...[详细]

尽管经历了多次“分分合合”,三星和高通都始终保持着亦敌亦友的微妙关系。根据韩国《电子时报》报道,高通可能会将骁龙830另一种说法是取名为骁龙835)由三星10nm工艺独家制造,作为交换,拿下全部订单的

...[详细]开发商Arc System Works 35周年纪念网站上线

著名游戏开发商 Arc System Works 日前上线了公司 35 周年纪念网站。这家开发了《罪恶装备》、《夜下降生》等热门格斗游戏的公司最早于 1988 年 5 月 12 日成立。周年纪念网站目

...[详细]

著名游戏开发商 Arc System Works 日前上线了公司 35 周年纪念网站。这家开发了《罪恶装备》、《夜下降生》等热门格斗游戏的公司最早于 1988 年 5 月 12 日成立。周年纪念网站目

...[详细] 今日早盘,截至11:00,6G概念板块下挫。*ST华讯(000687CN)跌4.86%报1.76元,亚光科技(300123CN)跌2.02%报9.22元,信维通信(300136CN)跌1.76%报27

...[详细]

今日早盘,截至11:00,6G概念板块下挫。*ST华讯(000687CN)跌4.86%报1.76元,亚光科技(300123CN)跌2.02%报9.22元,信维通信(300136CN)跌1.76%报27

...[详细] 从今天开始,支付宝正式对个人用户实行提现收费。支付宝提现涉及“提现到本人银行卡”和“转账到他人银行卡”两个功能,超出 2 万元免费额度的部分都会按照提现金额的 0.1 % 收取服务费,单笔服务费不到

...[详细]

从今天开始,支付宝正式对个人用户实行提现收费。支付宝提现涉及“提现到本人银行卡”和“转账到他人银行卡”两个功能,超出 2 万元免费额度的部分都会按照提现金额的 0.1 % 收取服务费,单笔服务费不到

...[详细] 《糖豆人》第4赛季现已正式推出,与“哆啦A梦”联动的皮肤套装也同步上线,该套装以电影《哆啦A梦 大雄与天空的理想乡》为主题设计,玩家可于北京时间 5 月 10 日晚上 6 点至 5 月 15 日晚上

...[详细]

《糖豆人》第4赛季现已正式推出,与“哆啦A梦”联动的皮肤套装也同步上线,该套装以电影《哆啦A梦 大雄与天空的理想乡》为主题设计,玩家可于北京时间 5 月 10 日晚上 6 点至 5 月 15 日晚上

...[详细] 上个月的时候,小米创始人雷军发布了一条回顾小米经历的微博,其中有一句是说在2019年的时候,小米正式进入了全球500强,当时小米是以总排名第468位,上榜中国企业中排名第112位,全球互联网企业中排名

...[详细]

上个月的时候,小米创始人雷军发布了一条回顾小米经历的微博,其中有一句是说在2019年的时候,小米正式进入了全球500强,当时小米是以总排名第468位,上榜中国企业中排名第112位,全球互联网企业中排名

...[详细]央行上海总部:10月人民币存款增加3311亿元 住户存款减少72亿元

11月15日,央行上海官网发布2021年10月份上海货币信贷运行情况,数据显示,10月末,上海本外币存款余额17.2万亿元,同比增长14.4%;人民币存款余额15.96万亿元,同比增长13.8%,增速

...[详细]

11月15日,央行上海官网发布2021年10月份上海货币信贷运行情况,数据显示,10月末,上海本外币存款余额17.2万亿元,同比增长14.4%;人民币存款余额15.96万亿元,同比增长13.8%,增速

...[详细]摩托罗拉moto razr 2022正式发布 骁龙8+折叠屏5999起

在今天中午两点,摩托罗拉召开了“三舰齐发顶峰相见”新品发布会,正式发布了旗下的折叠屏旗舰motorazr2022。motorazr2022搭载第三代星轨转轴,内屏拥有6层的深度支撑结构,包含UTG超薄

...[详细]

在今天中午两点,摩托罗拉召开了“三舰齐发顶峰相见”新品发布会,正式发布了旗下的折叠屏旗舰motorazr2022。motorazr2022搭载第三代星轨转轴,内屏拥有6层的深度支撑结构,包含UTG超薄

...[详细]